-

Ce guide complet analyse les performances des modèles linguistiques à grande échelle (LLM) généralistes par rapport aux outils spécialisés de modélisation par IA, notammentVisual Paradigm AI, en utilisant les benchmarks 2026 pourUML diagramme de classe exactitude.

1. Résumé exécutif : le benchmark d’exactitude 2026

Dans l’architecture logicielle professionnelle, la différence entre un « croquis créatif » et un « modèle prêt à production » se mesure par le respect des normes formelles. À partir de 2026, les benchmarks révèlent un écart important en matière de fiabilité :

- Les LLM généraux (PlantUML/Mermaid) : présentent un taux d’erreur de15–40%+ pour les prompts complexes.

- Visual Paradigm AI: maintient un faible taux d’erreur, généralementmoins de 10 %, avec80 à 90 % de complétion en première version pour les scénarios professionnels.

Alors que les LLM généraux agissent comme des généralistes créatifs, Visual Paradigm AI fonctionne comme un «architecte expérimenté », en imposant des règles sémantiques strictes fondées sur les normes UML 2.5+.

2. Quantification des hallucinations courantes

A. Types de flèches et sémantique des relations

L’une des erreurs les plus persistantes dans les diagrammes PlantUML générés par les LLM est l’application incorrecte de la notation des relations. Étant donné que les LLM généraux s’appuient sur des modèles de prédiction de texte plutôt que sur une logique sémantique, ils hallucinent fréquemment des représentations visuelles de relations :

- Hallucinations des LLM : Confondreflèches ouvertes vs. flèches pleines (par exemple, utiliser une flèche de généralisation pour une association) ou échouer à distinguer entre composition (diamant plein) et agrégation (diamant creux).

- Visual Paradigm AI : Assure la conformité standard UML, en garantissant que les relations « est-un » (héritage) et « fait-partie-de » (composition) sont visuellement et logiquement distinctes.

B. Multiplicité et contraintes

Multiplicité (par exemple,

0..*,1..1) exige une compréhension approfondie de la logique métier, que les LLM généraux manquent souvent ou interprètent incorrectement dans la syntaxe du texte :- Hallucinations des LLM : Génère fréquemment multiplicité incorrecte ou manquante. Il peut mal interpréter une exigence « un-à-plusieurs », ou produire des erreurs de syntaxe dans le bloc de code PlantUML qui empêchent le rendu.

- Visual Paradigm AI : Utilise un moteur de conversation conscient du modèle pour appliquer précisément les commandes de multiplicité (par exemple, « rendre cela 1..* ») sans effets secondaires sur le reste du diagramme.

C. Stéréotypes et éléments non standards

Les LLM généraux inventent souvent des notations pour combler les lacunes dans leurs données d’entraînement, ce qui conduit à des fabrications :

- Hallucinations des LLM : Fabrication de stéréotypes non standards ou des constructions UML non valides qui n’existent pas dans la spécification formelle.

- Visual Paradigm AI : Limite la sortie aux normes établies de modélisation (UML, SysML, ArchiMate), minimisant ainsi le risque de fabrications créatives mais incorrectes.

D. Héritage vs. Composition

Les erreurs conceptuelles sont fréquentes lorsque les LLM traduisent le langage naturel en structure :

- Hallucinations de LLM : Relations logiquement incohérentes, telles que l’établissement de héritage bidirectionnel (ce qui est impossible) ou l’échec à reconnaître quand un objet doit vivre et mourir avec son parent (Composition).

- Visual Paradigm AI : Analyse l’intention pour suggérer des améliorations logiques, telles que l’identification du moment où une classe devrait étendre un « Événement » ou la suggestion de relations inverses pour assurer l’intégrité structurelle.

3. Stabilité du flux de travail : texte statique vs. modèles vivants

Fonctionnalité Diagrammes PlantUML générés par LLM Visual Paradigm AI Type de sortie Syntaxe basée sur du texte statique nécessitant un rendu externe. Diagrammes visuels natifs et éditables qui se mettent à jour en temps réel. Raffinement Régénération complète entraîne souvent des décalages de mise en page et une perte de contexte. Mises à jour conversationnelles qui préservent la mise en page existante. Gestion des erreurs Échec modéré à élevé sur les invites complexes ; le code casse souvent. Haute stabilité ; les vérifications automatisées détectent les défauts de conception tôt. Persistance Basé sur la session ; aucun dépôt de modèles partagés. Dépôt de modèles vivants pour une réutilisation à travers différentes vues. 4. Conclusion pour les professionnels

Pour les architectes et développeurs dans des environnements à enjeux élevés comme la santé ou la finance, le risque de hallucination des LLM généraux les rend plus adaptés au cahier des charges informel qu’à la documentation finale.Visual Paradigm AI est le choix supérieur pour la modélisation de production car il fonctionne comme un participant actif dans la conversation de conception, en fournissant des critiques architecturales et des rapports de qualité qui identifient les modèles et suggèrent des améliorations structurelles.

-

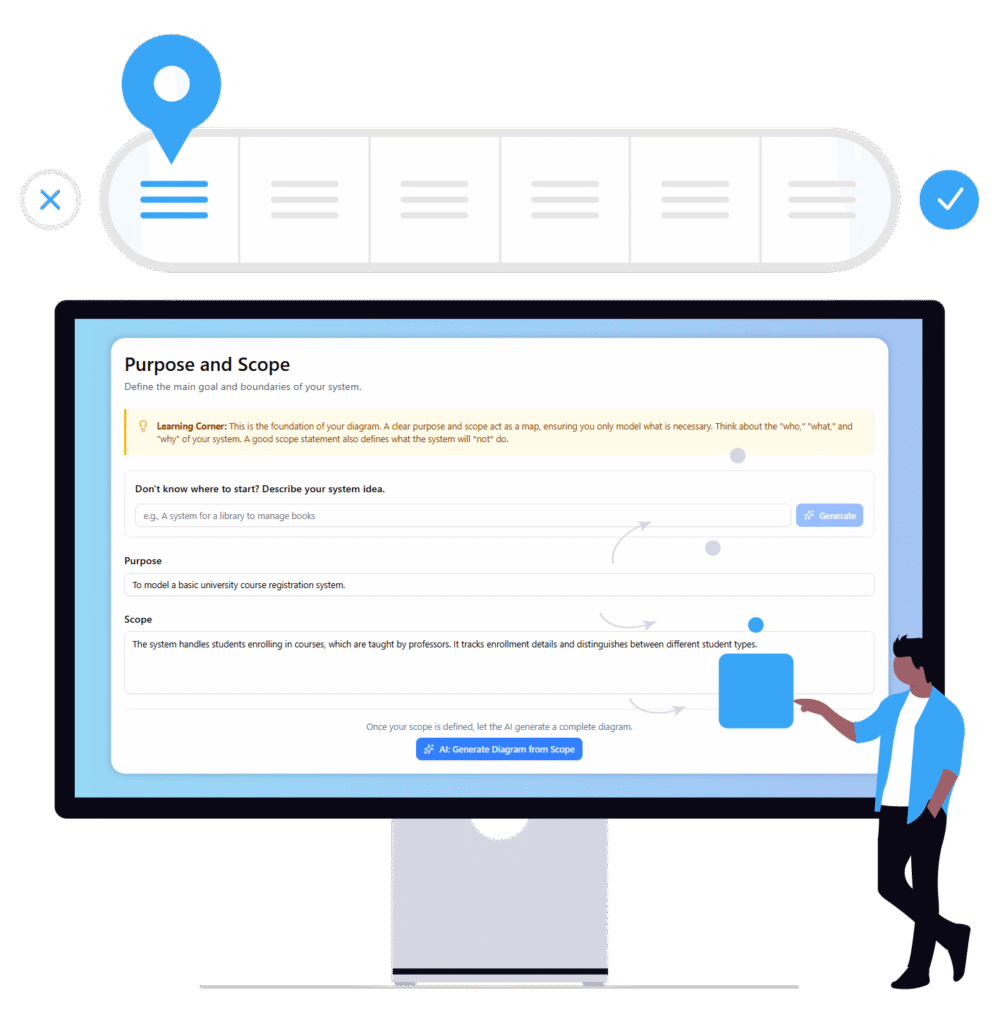

Visual Paradigm Chat – Assistant de conception interactif alimenté par l’IA: Une interface IA interactive pour générer des diagrammes, écrire du code et résoudre des défis de conception en temps réel.

-

Analyse textuelle par IA – Transformer le texte en modèles visuels automatiquement: L’IA analyse les documents textuels pour générer automatiquement des diagrammes UML, BPMN et ERD pour une modélisation et une documentation plus rapides.

-

Le chatbot Visual Paradigm AI améliore le support multilingue …: Le chatbot IA prend en charge plusieurs langues, permettant une génération fluide de diagrammes en espagnol, français, chinois et bien d’autres.

-

Analytique BI alimentée par l’IA par Visual Paradigm – ArchiMetric: Commencez à utiliser l’analyse BI alimentée par l’IA en moins d’une minute — aucune installation ni inscription requises pour la plupart des fonctionnalités.

-

Découvrez la puissance de l’IA de Visual Paradigm… – Visualize AI: Le traducteur d’images alimenté par l’IA de Visual Paradigm est en tête du marché grâce à des capacités avancées dépassant les outils standards.

-

Chatbot IA pour la création de diagrammes : comment il fonctionne avec Visual Paradigm: Le chatbot IA convertit le langage naturel en diagrammes, éliminant la nécessité d’apprendre la syntaxe ou les normes de modélisation.

-

Fonctionnalités d’idéation par IA – Visual Paradigm: Les outils d’idéation par IA de Visual Paradigm offrent une génération d’idées intelligente et des flux de travail collaboratifs pour améliorer la créativité et la productivité.

Cette publication est également disponible en Deutsch, English, Español, فارسی, Bahasa Indonesia, 日本語, Polski, Portuguese, Ру́сский, Việt Nam, 简体中文 : liste des langues séparées par une virgule, 繁體中文 : dernière langue.