Ewolucja projektowania baz danych

Projektowanie schematu bazy danych jest szkicem nowoczesnej architektury oprogramowania. Źle zaprojektowany schemat prowadzi do anomalii danych, wolnej wydajności i ograniczeń skalowalności. Tradycyjnie normalizacja – proces organizowania danych w celu zmniejszenia nadmiarowości i poprawy integralności danych – była pracą ręczną, ciężką i wymagającą głębokiej wiedzy teoretycznej z zakresu algebry relacyjnej. Jednak pojawienie się sztucznej inteligencji przełomowo zmieniło tę fazę rozwoju.Normalizacja z wykorzystaniem sztucznej inteligencji optymalizuje schemat bazy danych poprzez stopniowe doskonalenie jego struktury w celu usunięcia nieefektywności i zapewnienia solidnej integralności danych.

Zrozumienie normalizacji z wykorzystaniem sztucznej inteligencji

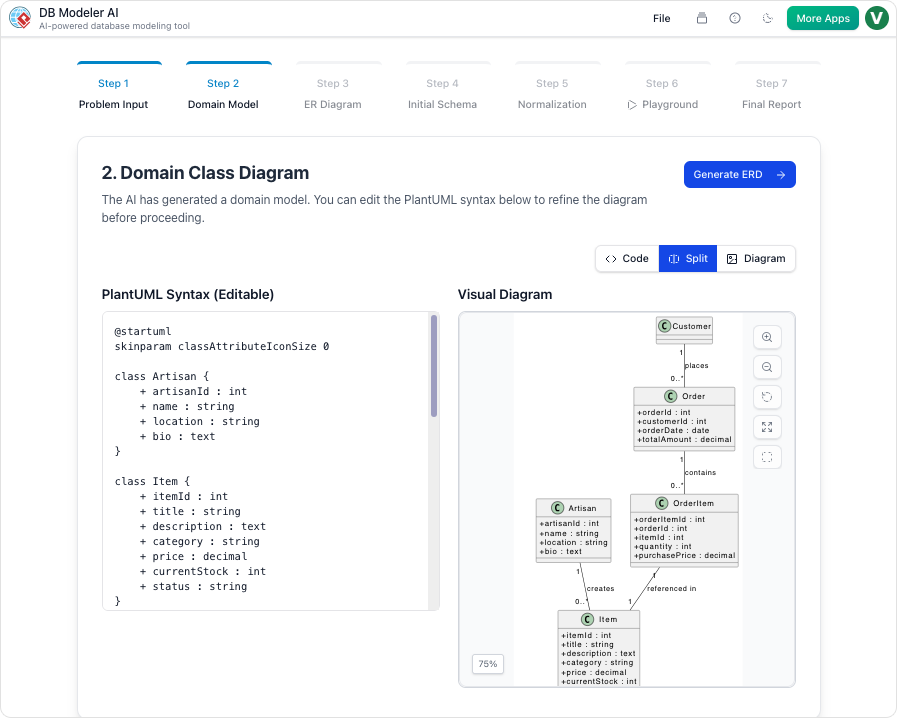

W swoim centrum, normalizacja z wykorzystaniem sztucznej inteligencji działa jak automatyczny architekt. W zaawansowanych platformach, takich jakDB Modeler AI przepływ, ten proces odbywa się jako automatyczna „Inteligentna normalizacja” (konkretnie oznaczona jako Krok 5 w przepływie). AI analizujemodel danych koncepcyjnych i systematycznie go przekształca, aby odpowiadał standardom branżowym.

Analogia z szafką dokumentów

Aby wizualizować ten proces, wyobraź sobierozbrzmianie i uporządkowanie chaotycznej szafki dokumentów. W systemie nieuporządkowanym informacje kontaktowe klienta mogą być zapisane na dwudziestu różnych folderach projektowych. Oznacza tonadmiarowość danych. Jeśli klient zmienia adres, musisz zaktualizować dwadzieścia oddzielnych plików, zwiększając ryzyko błędu. Normalizacja z wykorzystaniem sztucznej inteligencji działa jak profesjonalny organizator: identyfikuje te duplikaty, tworzy jedno główne plik dla klienta i wstawia prosty „klucz odniesienia” w folderach projektowych wskazujący na ten główny plik. Ta metoda oszczędza miejsce na dysku, przyspiesza możliwości wyszukiwania i zapewnia, że jedna aktualizacja odzwierciedla się we wszystkich częściach systemu.

Podstawowe mechanizmy optymalizacji

Proces optymalizacji w narzędziach modelowania opartych na sztucznej inteligencji działa poprzez kilka zaawansowanych mechanizmów zaprojektowanych w celu mostu między surowymi koncepcjami a strukturami gotowymi do produkcji.

1. Stopniowy postęp (1NF do 3NF)

AI nie tylko naprawia bazę danych; systematycznie ją przekształca. Silnik prowadzi schemat przezPierwszą (1NF), Drugą (2NF) i Trzecią (3NF) Formę Normalną. Stopniowy postęp zapewnia, że struktura bazy danych ściśle odpowiadazasadom modelowania relacyjnego, eliminując powtarzające się grupy i zapewniając, że atrybuty niekluczowe są zależne od klucza głównego.

2. Usuwanie nadmiarowości

Głównym zadaniem normalizacji z wykorzystaniem sztucznej inteligencji jest identyfikacja iusuwanie nadmiarowości danych. Poprzez skrupulatne zmniejszanie danych powtarzających się, AI minimalizuje nadmiar pamięci i zapobiega „anomalii aktualizacji”, które atakują systemy nieznormalizowane.

3. Zapewnienie integralności danych

Normalizacja stanowi fundament oprogramowania skalowalnego poprzez zapewnienieintegralności danych. AI organizuje tabele i ustanawia relacje kluczy obcych, abydane pozostawały spójnei dokładne w całym ekosystemie, niezależnie od objętości transakcji.

Jak AI DB Modeler Visual Paradigm przekształca proces

Visual Paradigm zintegrował te zasady bezpośrednio w swoimAI DB Modeler, przekształcając sposób, w jaki deweloperzy i architekci podejmują projektowanie bazy danych. Narzędzie tworzy bezproblemowy most między wymaganiami w języku naturalnym a implementacją techniczną.

Automatyczna inteligencja i wartość edukacyjna

Jedną z wyraźnych zalet podejścia Visual Paradigm jest uwzględnienieuzasadnień edukacyjnych. W przeciwieństwie do tradycyjnych narzędzi, które bezszelestnie wykonywają polecenia, AI dostarcza inteligentne wyjaśnienia dla każdej zmiany strukturalnej, jaką sugeruje. Ta przejrzystość pozwala użytkownikom zrozumieć „dlaczego” za zmianami architektonicznymi – np. dlaczego tabela została podzielona lub relacja zmieniona – działając jako potężnenarzędzie do nauki najlepszych praktyk projektowania.

Od koncepcji do gotowego do produkcji wyjścia

Ostatecznym celem AI DB Modeler jest implementacja. Po zakończeniu kroku normalizacji model koncepcyjny abstrakcyjny jest przekształcany wpełnie zoptymalizowany, gotowy do produkcji schemat SQL. To wyjście nie jest tylko teoretyczne; jest gotowe do natychmiastowego testowania w interaktywnym środowisku lub do bezpośredniej implementacji za pomocąeksportowanych skryptów DDL. Ta automatyzacja od początku do końca drastycznie skraca czas wypuszczenia nowych aplikacji, zapewniając przy tym solidną, skalowalną i standaryzowanąpodstawę danychpodstawę danych.

Ten post dostępny jest również w Deutsch, English, Español, فارسی, Français, Bahasa Indonesia, 日本語, Portuguese, Ру́сский, Việt Nam, 简体中文 and 繁體中文