Die Entwicklung der Datenbankgestaltung

Datenbank-Schemagestaltung ist der Bauplan der modernen Softwarearchitektur. Eine schlecht gestaltete Schema führt zu Datenanomalien, schlechter Leistung und Skalierbarkeitsengpässen. Traditionell war die Normalisierung – der Prozess der Datenorganisation zur Reduzierung von Redundanz und Verbesserung der Datenintegrität – eine manuelle, mühsame Aufgabe, die tiefgreifendes theoretisches Wissen über die relationale Algebra erforderte. Doch das Aufkommen der künstlichen Intelligenz hat diese Phase der Entwicklung revolutioniert.KI-Normalisierung optimiert ein Datenbankschema, indem es seine Struktur schrittweise verfeinert, um Effizienzverluste zu beseitigen und eine robuste Datenintegrität sicherzustellen.

Verständnis der KI-Normalisierung

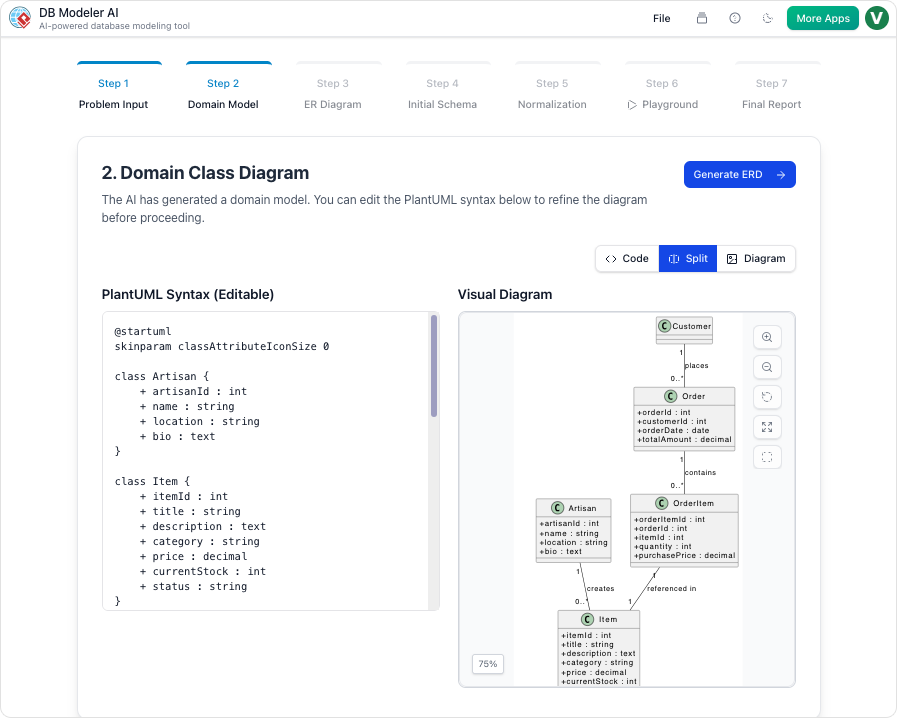

Im Kern fungiert die KI-Normalisierung als automatisierter Architekt. In fortgeschrittenen Plattformen, wie der DB Modeler KIWorkflow tritt dies als automatisierter „Intelligente Normalisierung“-Stadium auf (genau als Schritt 5 im Workflow festgelegt). Die KI analysiert ein konzeptuelles Datenmodell und organisiert es systematisch um, um den Branchenstandards zu entsprechen.

Die Aktenkasten-Analogie

Um diesen Prozess zu visualisieren, stellen Sie sich vor die Aufräumung und Organisation eines chaotischen Aktenkastens. In einem ungeordneten System könnte die Kontaktdaten eines Kunden auf zwanzig verschiedenen Projektordnern vermerkt sein. Dies stellt Datenredundanz. Wenn sich der Kunde versetzt, müssen Sie zwanzig separate Dateien aktualisieren, was das Risiko von Fehlern erhöht. Die KI-Normalisierung wirkt wie ein professioneller Organizer: Sie erkennt diese Duplikate, erstellt eine einzige Masterdatei für den Kunden und fügt in den Projektordnern einen einfachen „Referenzschlüssel“ ein, der auf diese Masterdatei verweist. Diese Methode spart Speicherplatz, beschleunigt die Suchfunktionen und stellt sicher, dass eine einzige Aktualisierung sich über das gesamte System auswirkt.

Die zentralen Mechanismen der Optimierung

Der Optimierungsprozess innerhalb kI-gestützter Modellierungswerkzeuge funktioniert durch mehrere anspruchsvolle Mechanismen, die darauf abzielen, die Lücke zwischen groben Konzepten und produktionsfertigen Strukturen zu schließen.

1. Schrittweise Fortschreibung (1NF bis 3NF)

Die KI patcht die Datenbank nicht nur; sie rekonstruiert sie systematisch. Die Engine führt das Schema durch die Erste (1NF), Zweite (2NF) und Dritte (3NF) Normalform. Diese schrittweise Fortschreibung stellt sicher, dass die Datenbankstruktur streng an prinzipien der relationalen Modellierunggehalten wird, wodurch sich wiederholende Gruppen beseitigt und sichergestellt wird, dass nicht-schlüsselbasierte Attribute vom Primärschlüssel abhängen.

2. Redundanzbeseitigung

Ein zentrales Ziel der KI-Normalisierung ist die Identifizierung und Beseitigung der Datenredundanz. Durch die strikte Reduzierung von doppelten Daten minimiert die KI den Speicherbedarf und verhindert die „Aktualisierungsanomalien“, die denormalisierte Systeme belasten.

3. Sicherstellung der Datenintegrität

Die Normalisierung dient als Grundlage für skalierbare Software, indem sie sicherstelltDatenintegrität. Die KI ordnet Tabellen und stellt Fremdschlüsselbeziehungen her, damitdie Daten konsistent bleiben und genau im gesamten Ökosystem sind, unabhängig vom Transaktionsvolumen.

Wie der AI-DB-Modeler von Visual Paradigm den Prozess transformiert

Visual Paradigm hat diese Prinzipien direkt in seinenAI-DB-Modeler, wodurch sich die Herangehensweise von Entwicklern und Architekten an die Datenbankgestaltung verändert. Das Tool bietet eine nahtlose Brücke zwischen natürlichsprachlichen Anforderungen und technischer Umsetzung.

Automatisierte Intelligenz und Bildungswert

Ein wesentlicher Vorteil des Ansatzes von Visual Paradigm ist die Einbeziehung vonbildende Begründungen. Im Gegensatz zu traditionellen Tools, die Befehle still ausführen, liefert die KI intelligente Erklärungen für jede vorgeschlagene strukturelle Änderung. Diese Transparenz ermöglicht es Benutzern, das „Warum“ hinter architektonischen Veränderungen zu verstehen – beispielsweise warum eine Tabelle aufgeteilt oder eine Beziehung verändert wurde – und fungiert als ein leistungsfähigesLernwerkzeug für Best-Practice-Design.

Von der Idee bis zur produktionsfertigen Ausgabe

Das endgültige Ziel des DB-Modeler-KI ist die Umsetzung. Nach Abschluss des Normalisierungsschritts wird das abstrakte Konzeptmodell in einvollständig optimiertes, produktionsfähiges SQL-Schema. Diese Ausgabe ist nicht nur theoretisch; sie ist sofort für die Tests in einer interaktiven Umgebung oder für die direkte Umsetzung überexportierte DDL-Skripte. Diese End-to-End-Automatisierung reduziert die Zeit bis zur Marktreife neuer Anwendungen erheblich, während sie sicherstellt, dass die zugrundeliegendeDatenbasisfest, skalierbar und standardisiert ist.

Der Artikel ist auch in English, Español, فارسی, Français, Bahasa Indonesia, 日本語, Polski, Portuguese, Ру́сский, Việt Nam, 简体中文 and 繁體中文 verfügbar.